Computer, Zubehör und Gaming

ANZEIGE: Home Internet Blog-Tipps Computer, Zubehör und Gaming

Wer Interesse an Computern hat, ist in der Regel auch leidenschaftlicher Gamer. Dies liegt nahe, da leistungsstarke Computer benötigt werden, um die aktuellsten Videospiele zu spielen. Meist fängt das Interesse an Computern im Kindesalter an und steigt über die Jahre. Oftmals hängt dies damit zusammen, dass Kindern die Welt der Videospiele präsentiert wird und sie ein Interesse dafür entwickeln.

Vor einigen Jahren war das Spielen von Videospielen noch verpönt, aber inzwischen ist es zum Mainstream geworden und Wissenschaftler haben bewiesen, dass Videospiele gut für das menschliche Gehirn sind. In vielen Spielen müssen Rätsel gelöst werden, die nicht allzu einfach sind und teilweise sehr viel Geduld und Konzentration benötigen. Ähnlich ist es bei schwierigen Spielen, die nur von den besten Gamern gemeistert werden können, was ebenfalls einiges an Fähigkeit, Talent und Fleiß erfordert. Außerdem sind Videospiele gut für die Handaugenkoordination, welche in vielen Bereichen der wahren Welt gefragt ist.

Computer: Hard- und Software

Wie bereits erwähnt, benötigen die neusten Spiele meist die beste Hard- und Software auf dem Markt, um sie optimal zu spielen. Deshalb ist es wichtig, dass in diesen Bereichen investiert wird, wenn neue Spiele herauskommen. Inzwischen sind zwar vor allem die Grafikkarten extrem teuer, aber mit den richtigen Tricks kann auch dabei gespart werden. Wer beispielsweise zu den richtigen Momenten bei einer Grafikkarte zugreift, kann manchmal ein Schnäppchen machen. Ein Zauberwort dafür ist Black Friday, an welchem Tag die meisten elektronischen Geräte deutlich reduziert erhältlich sind. Außerdem muss auch nicht jedes Jahr die neuste Grafikkarte gekauft werden, sondern nur dann, wenn die alte Grafikkarte nicht mehr zu den Besten gehört. Es reicht in der Regel aus, wenn diese alle drei bis vier Jahre erneuert wird. Ähnlich ist es bei den anderen Hardwarekomponenten, wobei manche über noch längere Zeit behalten werden können.

Im Endeffekt wird somit nicht viel Geld für den Computer ausgegeben, selbst wenn die Beträge für Grafikkarten inzwischen an die tausend Euro sind. Wenn dies aber nur einmal in vier Jahren passiert, dann kann daraufhin gespart werden. Außerdem ist Gaming meist ein günstiges Hobby, das mit einmaligen Käufen verbunden ist. Wer lieber zu Hause ist und Videospiele genießt, gibt auf jeden Fall weniger Geld aus als jemand, der jedes Wochenende auf einer Party zu sehen ist. Dies ist ein Fakt und dafür wird kein Finanzmanagement Fernstudium benötigt, um dies zu bestätigen.

Logitech – Boom bei Computer-Zubehör – schafft die Aktie die Trendwende?

Bottom-Fishing Trading-Strategie

Symbol: LOGN ISIN: CH0025751329

Rückblick: Die Corona-Krise hat die globalen Lieferketten durcheinandergebracht. Während der Lockdowns explodierte aber die Nachfrage nach Computer-Hardware und der dazugehörigen Peripherie. Die Kosten sorgten für einen Gewinnrückgang bei dem Anbieter von Computer-Zubehör. Nachdem die Aktie im Juni ihr Rekordhoch erreicht hatte, ging es in den letzten Monaten unter dem EMA-20 stetig bergab. Nun könnte das Papier des Computer-Zubehör-Spezialisten einen Boden gefunden haben.

Meinung: Logitech profitiert von der gestiegenen Nachfrage durch die zunehmenden Trends der Arbeit und dem Lernen von zu Hause aus. Auch das Metaversum bietet für Logitech Chancen. Interaktivere Tastaturen, Mäuse und Kameras könnten die Metaverse-User miteinander verbinden und interagieren lassen. Die Aktie konnte in den letzten Tagen den EMA-20 zurückerobern und hat nun über diesem gleitenden Durchschnitt eine Base ausgebildet. Wenn es die Bullen schaffen, nach oben auszubrechen und auch den EMA-50 zu überwinden, stehen die Chancen nicht schlecht, dass die Aktie in Folge die Trendwende schaffen könnte.

Chart vom 17.12.2021 – Basis täglich, 6 Monate – Kurs: 76.60 CHF

Setup: Bei einem Ausbruch aus der Base könnte sich die Eröffnung einer Long-Position lohnen. Diese ließe sich nach dem Entry unter der Range, unter dem EMA-20 absichern.

Jeden Börsentag neu: präzise Setups im Alphatrader von ratgeberGELD.at.

Meine Meinung zu Logitech ist neutral

Autor: Wolfgang Zussner besitzt aktuell keine Positionen in LOGN

Bitte nehmen Sie den Disclaimer, die Interessenskonflikte und die Risikohinweise zur Kenntnis, die Sie unter https://ratgebergeld.at/disclaimer/ abrufen können.

Computerhardware für Anfänger – Wikibooks, Sammlung freier Lehr-, Sach- und Fachbücher

Auszeichnung:

Buch des Monats

April 2007 Sie möchten eine PDF-Datei (130 Seiten) erstellen oder das Buch auf Papier haben? Wie das geht, können Sie hier lesen.

Etwas ist schwer verständlich oder unverständlich? Sie vermissen ein Thema? Bitte helfen Sie mir und zukünftigen Lesern, das Buch zu verbessern! Bitte klicken Sie hier und schreiben Sie einfach Ihre Frage auf, was immer es ist. Sie finden hier in wenigen Tagen eine Antwort! Es ist eine EPUB-Version dieses Buches vorhanden.

Dieses Buch wurde in die Liste exzellenter Bücher aufgenommen.

Grundlagenwissen

Die Grundlagen für die heutigen PC wurden schon vor sehr langer Zeit gelegt. Die ersten Computer wurden in den vierziger Jahren gebaut. Grafische Bedienoberflächen gibt es seit den fünfziger Jahren. Der erste erfolgreiche Heimcomputer war der „Altair 8800“ im Jahr 1974. 1981 brachte IBM den „Personal Computer“ auf den Markt, und Teile von dessen Bauplan stecken auch heute noch in jedem PC. Die Reklame und die Fachzeitschriften vermitteln uns den Eindruck, es würden ständig revolutionäre Innovationen eingeführt. Mitunter wird sogar technologischer Rückschritt als Fortschritt deklariert. Natürlich wissen Sie, dass Reklame nicht den Zweck hat, Sie zu informieren, sondern Sie zum Kauf zu animieren („Das ist neu! Das müssen Sie unbedingt kaufen!“), und Fachzeitschriften müssen sich mit reißerischen Artikeln von der Konkurrenz abheben und über jede „Neuheit“ und jedes Gerücht als Erste schreiben.

Haben Sie schon einmal darüber nachgedacht, dass beim PC „Neu“ oftmals bedeutet

„Voreilig auf den Markt geworfen und noch nicht in der Praxis bewährt“

„Die Nachbesserungen werden im Internet veröffentlicht, der Kunde wird sie dort schon finden.“

„Wenn 80% der Käufer zufrieden sind, reicht es aus.“ Oder genauer: „Gekauft ist gekauft. Wir haben das Geld des Kunden, und die Reklamationen werden von der Serviceabteilung abgeschmettert.“ Außerdem ist die Gewinnspanne bei Reparaturen und Ersatzteilen viel höher als beim Verkauf, vor allem bei Notebooks.

Aber wo sind denn die wirklichen Innovationen zu finden?

1948 wurde der Transistor erfunden und Norbert Wiener begründete die Kybernetik. Die Schaltungen und Verfahren, nach denen CPU RAM ROM Magnetische Speicherverfahren gibt es schon lange: Die Tonaufzeichnung auf Stahldraht wurde bereits 1899 patentiert. Etwa 1940 erreichten Magnetbandgeräte die Praxisreife. Die Computer der 50er Jahren benutzten Magnettrommelspeicher als Arbeitsspeicher. Diese Technologien bereiteten den Weg für die 1956 entwickelte erste Festplatte und für die 1969 erfundene Diskette. Geschwindigkeit und Kapazität sind Jahr für Jahr gestiegen und der Preis pro Byte ist gefallen, doch die technologischen Grundlagen sind seit mehr als 100 Jahren unverändert. 1974 entwickelte Intel 8-Bit-Prozessor „kompatibel“ IBM AMD Im Jahr 1964 wurde die Maus erfunden, um die Arbeit mit Computern bedienerfreundlicher zu gestalten. 1973 wurde für den „Xerox Alto“ eine „grafische Bedienoberfläche“ entwickelt (engl. Graphical User Interface, abgekürzt GUI). Es dauerte 20 Jahre, bis man eine sinnvolle Verwendung für die Maus gefunden hatte: Mit dem „Amiga“ erreichte die Maus 1985 den Massenmarkt. 1990 hatte Microsoft erste Erfolge mit einem grafischen Zusatz für das Betriebssystem DOS, der den Namen „Windows“ erhielt. Damals konnte jeder wählen, ob er lieber kryptische DOS-Befehle eintippen will oder ob er den Computer mit der Maus bedient. Seit 2002 gibt es ein „Hyper-Threading“ genanntes Verfahren: Wenn bei der Abarbeitung eines Programmteils eine Wartezeit eintritt (z. B. weil die Daten aus dem Arbeitsspeicher noch nicht eingetroffen sind), wird zu einem anderen Programmteil gewechselt. 2006 wurden die ersten „Dual Core“-CPUs verkauft, die zwei Rechenwerke in der CPU enthalten. Doch neu ist die Parallelverarbeitung nicht. Bereits der britische „Colossus“, der 1943 zur Entschlüsselung von Geheimcodes eingesetzt wurde, war ein Parallelrechner. Heutige Supercomputer verteilen ihre Arbeit auf zehntausende Prozessoren.

Auch auf dem Gebiet der Software wurden viele der Grundlagen schon vor Jahrzehnten gelegt:

1974 wurde das Betriebssystem MS-DOS 1.0 xcopy c:users*.doc a:*.doc /d /s /e /y . Solche Kommandozeilenbefehle Bei jeder neuen Version eines Betriebssystems achten die Entwickler darauf, dass neben allen Verbesserungen auch sämtliche alten Befehle weiterhin funktionieren. Wenn Sie auf ein moderneres Betriebssystem umsteigen, können Sie Ihre älteren, lieb gewonnenen Programme weiter verwenden und natürlich auch Ihre Daten weiter benutzen. Durch dieses freundliche Prinzip, die Abwärtskompatibilität, kann ich auch heute noch die meisten Befehle verwenden, die ich in den 80er Jahren gelernt habe. Allerdings hat die Abwärtskompatibilität auch Grenzen. In jeder neuen Version des Betriebssystems die „Andockstellen“ für ältere Programme mitzuschleppen ist aufwändig. Irgendwann, nach etwa zehn bis fünfzehn Jahren, halten die Hersteller den Aufwand nicht mehr sinnvoll, weil (angeblich) kaum noch jemand die Uraltprogramme nutzt. Windows XP, Vista, Windows 7, 8, 10 und 11 kommen beim Start ohne DOS aus. Doch die klassischen DOS-Befehle sind nicht verschwunden. Alle Windows-Versionen besitzen ein Fenster für DOS-Befehle, die sogenannte Eingabeaufforderung. Im Laufe der Jahre wurden die DOS-Befehle weiterentwickelt. Weil viele neue Befehle hinzugekommen sind, spricht man nicht mehr von DOS-Befehlen, sondern von Kommandozeilenbefehlen. Das Befehlssortiment ist so umfangreich, dass sich moderne Windows-Betriebssysteme für Server vollständig mit Kommandozeilenbefehlen installieren, konfigurieren und bedienen lassen, ohne auch nur ein einziges Mal die Maus benutzen zu müssen. Es gibt nicht nur das fast immer verwendete Windows als Betriebssystem für PCs, sondern auch eine Vielfalt an alternativen Betriebssystemen, von denen Linux das bekannteste ist. Die Wurzeln dieser Betriebssysteme reichen meist noch weiter zurück als die von Windows. Der größte Teil der Smartphones und Tablets benutzt das Betriebssystem „Android“, das auf Linux basiert. E-Mail ist auch nicht so neu, wie man denkt. Die ersten Versuche wurden bereits 1971 durchgeführt. Im Jahr 1979 stellte Eric Allman das Programm „Delivermail“ fertig, das 1981 in „Sendmail“ umbenannt wurde. Die übergroße Mehrzahl der E-Mail-Server benutzt dieses Programm auch heute noch in einer weiterentwickelten Version als „elektronisches Postamt“.

Hard- und Software wurden Jahr für Jahr in kleinen Schritten verbessert: höhere Taktfrequenzen, höhere Packungsdichten auf dem Chip und auf der Festplattenoberfläche, höhere Drehzahlen, mehr Farben usw. Durch Weiterentwicklung und Massenfertigung sind die Preise gesunken. Aber gibt es etwas grundsätzlich Neues? Nur selten.

Das bedeutet, dass ein solides Grundlagenwissen kaum veraltet. Es ist interessant, hilfreich und gewiss keine Zeitvergeudung, sich mit den Grundlagen zu beschäftigen.

Grundlagenwissen ist unumgänglich, um in „neuen“ Entwicklungen hinter den Werbeversprechen und Testberichten das Wesentliche zu erkennen und zu bewerten.

Grundlagenwissen ist notwendig, um den Verkäufer das Richtige fragen zu können, statt auf ihn hereinzufallen.

Grundlagenwissen hilft oft gerade dann weiter, wenn die Hard- oder Software „spinnt“ und einem allmählich die Ideen ausgehen, was man noch versuchen könnte.

Den meisten Leuten, die sich für Computer interessieren, fehlen diese Grundlagen vollkommen. In der Schule wird solches Wissen bisher nicht vermittelt. In Fachzeitschriften wird Grundlagenwissen leider nur selten und unsystematisch geboten. Die Redakteure und Autoren sind Computerfreaks und schreiben für andere Computerfreaks in deren Sprache.

Sicherlich hätten sich viele Computerprobleme und ein großer Teil der Datenverluste vermeiden lassen, wenn der Benutzer im entscheidenden Moment eine Vorstellung davon gehabt hätte, was sich gerade im Computer abspielt.

Wer mehr über seinen Computer weiß, wird weniger Probleme haben und weniger (teure und nervenaufreibende) Fehler begehen. Vielen Computerbenutzern, die sich eigentlich überhaupt nicht fur Technik interessieren, ist das bereits mehr oder weniger klar. Dieses Buch will Ihnen Grundlagenwissen vermitteln, das Ihnen bei realen praktischen Problemen hilft oder diese Probleme zu vermeiden hilft. Regeln und Empfehlungen werden begründet. Am wichtigsten aber ist:

Jeder kann dieses Buch verstehen, auch wenn er/sie sich eigentlich für Computertechnik überhaupt nicht interessiert. Natürlich werden Fachwörter verwendet, aber sie werden erklärt.

auch wenn er/sie sich eigentlich für Computertechnik überhaupt nicht interessiert. Natürlich werden Fachwörter verwendet, aber sie werden erklärt. Selbst erfahrenere Computerbenutzer werden einige interessante Gedanken finden können.

Damit Sie das Buch auch auszugsweise lesen können, sind einige Wiederholungen unvermeidlich. Schauen Sie bitte im Glossar nach, wenn Sie auf unbekannte Begriffe treffen, die vielleicht erst in späteren Kapiteln erläutert werden.

Und nun viel Spaß beim Lesen!

In diesem Buch geht es vor allem um den „klassischen“ Desktop-PC und um Notebooks. Aber Smartphones, Tablets und E-Reader bestehen aus den gleichen Komponenten. Akkus und Bildschirme beispielsweise leiden unter Minusgraden auf die gleiche Weise, gleichgültig ob sie in einem Smartphone oder in einem Notebook stecken.

Angesichts der Verkaufszahlen von Smartphones und Tablets meinen einige Leute, das Zeitalter der klobigen PCs ginge dem Ende zu. Wer seinen PC hauptsächlich für E-Mail, zum Surfen und für ein paar Office-Anwendungen benutzt, für den scheint ein Desktop-PC überdimensioniert zu sein. Er ist teuer, laut, kompliziert, viel zu groß und verbraucht zu viel Strom. Ein Flach-PC ist da vielleicht die bessere Wahl.

Doch der Desktop-PC kann vieles, was seine kleinen Geschwister nicht leisten können.

Schreiben mit einer Tastatur, mit der auch Vielschreiber zufrieden sind,

Speichern und Verwalten großer Datenmengen wie Fotos, Videos und Musik,

Arbeit mit mehreren Programmen gleichzeitig und einfacher Datenaustausch zwischen den Programmen,

Arbeit mit vielen Fenstern und Nutzung mehrerer Displays mit großen Bildschirmdiagonalen,

Präzises Arbeiten (stellen Sie sich Bildbearbeitung mit den Fingerspitzen auf einem 8" Display vor!),

Rechenintensive Anwendungen, wie z. B. Videoschnitt,

Nutzung als Home-Server, Steuerung von Haustechnik und Modellbahnanlagen,

Nutzung als Flugsimulator und für anspruchsvolle Spiele,

DVD und Blu-ray lesen und brennen.

Hinzu kommt noch seine vielfältige Erweiterbarkeit: Hochleistungs-Grafikkarte, diverse Schnittstellenkarten u. a.

Beachten Sie die Unmenge an Schnittstellen. Was können Sie nicht alles (gleichzeitig) anschließen: Externe Festplatten, USB-Speichersticks, Drucker, Scanner, Kameras, Skype-Headset, Smartphones ... Und wenn die Schnittstellen nicht ausreichen, steckt man eine Erweiterungskarte in den PC.

Außerdem schont der PC die Umwelt. Man kann problemlos defekte Teile auswechseln und das PC-Leben durch Aufrüstung verlängern. Einen defekten Tablet-Computer können Sie nicht reparieren. Selbst wenn Sie das zugeklebte Gehäuse aufbrechen, finden Sie keine Standardteile, die man ersetzen könnte. Aufrüsten geht auch nicht. Und die Müllberge wachsen ... Freilich benötigt ein Desktop-PC mehr Energie, doch der gesamte Energieaufwand bei der Herstellung der Rohmaterialien und Komponenten ist so groß, dass der Energieverbrauch beim Kunden kaum ins Gewicht fällt. Und ich bin schneller mit der Arbeit fertig und kann den PC früher ausschalten.

Hatten Sie jemals Gelegenheit zu vergleichen, wie viel schneller man mit einem Desktop-PC eine umfangreiche Internet-Recherche durchführen kann, im Vergleich zu einem Notebook oder gar einem Tablet? Ich kann mir nicht vorstellen, dass ein Firmenchef seine Innendienst-Mitarbeiter mit Notebooks oder Tablets ausstatten würde. Wo „Zeit ist Geld“ gilt, darf man an der Leistung der Computer nicht sparen.

Als der PC 1981 auf den Markt kam, war er eine Arbeitsmaschine. Niemand konnte sich damals vorstellen, welche Vielfalt von Anwendungen es einmal geben wird und dass der PC Einzug in die Haushalte nehmen würde. Und nun, nach drei Jahrzehnten, ist der PC auf dem Weg zurück zu den Profis und den Anwendern, die ihn für ihre Arbeit und für anspruchsvolle Hobbys benötigen. Für viele „Normalanwender“ genügt ein Tablet-Computer.

Elektronik-Grundbegriffe

Schnitt durch eine mehrlagige Platine.

Elektronische Bauelemente sind Widerstände, Kondensatoren, Relais, Schalter, Leitungen, Transformatoren, Batterien, Dioden, Transistoren, LED und andere. Eine elektronische Schaltung besteht aus elektronischen Bauelementen, die zu einer sinnvollen Funktion verbunden sind, z. B. Blinkgeber, Dämmerungsschalter, Verstärker.

Leiterplatten

Leiterplatte mit Bauelementen

Elektronische Bauelemente werden auf Leiterplatten montiert. Eine Leiterplatte (auch Platine, Board oder PCB von printed circuit board (engl.): gedruckte Schaltung) besteht im Regelfall aus einer 1 – 2 mm dicken Trägerplatte aus Isoliermaterial, häufig mit stabilisierenden Glasfasern. Auf der Oberfläche und oft auch innerhalb der Platte sind Leiterzüge aus Kupfer angeordnet. Zum Schutz vor Oxidation während des Herstellungsprozesses wird das Kupfer häufig verzinnt, versilbert oder sogar vergoldet und mit einer Isolationsschicht überzogen. Dies gibt der Leiterplatte das typisch grüne Aussehen. Wenn die Trägerplatte auf beiden Seiten Leiterzüge hat, wird die Leiterplatte zweilagig genannt (bei existierenden Innenlagen entsprechend mehrlagig). Die Platte wird gebohrt und die Bohrlöcher werden innen metallisiert, um die Leiterebenen miteinander zu verbinden. Zum Schluss werden Widerstände, Kondensatoren und weitere elektronische Bauelemente in die Bohrungen gesteckt und verlötet. Damit ist eine fertige elektronische Baugruppe entstanden, wie eine Hauptplatine oder ein Hauptspeichermodul.

Leiterplatte mit SMD-Bauelementen

Die Microchips in den Abbildungen haben „Beinchen“ (engl.: pin oder lead). Früher hatten alle Microchips „Beinchen“, heute findet man auch Lötkugeln (wie im Schnittbild rechts) oder schwarze Kleckse auf Platinen, wo die Microchips direkt mit der Leiterplatte verbunden sind. Die Industrie bevorzugt Chips mit SMD-Kontakten (Surface Mounted Device, deutsch: oberflächenmontiertes Bauelement), weil dadurch Bohrungen wegfallen und aufgrund der kleineren Anschlussflächen mehr Bauteile untergebracht werden können.

Halbleiter

Nach der elektrischen Leitfähigkeit unterscheidet man Isolatoren (z. B. Porzellan, Gummi, Kunststoff) und Leiter (z. B. Metalle). In hochreinen Silizium- und Germaniumkristallen gibt es bei niedrigen Temperaturen keine freien Elektronen für den Ladungstransport, sie sind dadurch sehr schlechte Leiter. Durch Hinzufügen winzigster Mengen Fremdatome (das Impfen mit Fremdatomen nennt man „Dotieren“, übliche Dosierung: 1 bis 100 Fremdatome auf eine Milliarde Atome) kann die Leitfähigkeit erhöht werden und das Material wird so zum Halbleiter.

Außerdem kann man den Stromfluss erhöhen

durch Erhöhung der Temperatur,

durch Bestrahlung mit Licht und

durch elektrische Felder.

Ein n-Halbleiter wird durch Dotieren mit z. B. Phosphor hergestellt. Weil Phosphor leicht Elektronen (die negativ geladen sind) abgibt, entsteht ein winziger Elektronenüberschuss. Dadurch wird ein Stromfluss, also Ladungstransport, möglich. Weil dieser von der Dotierung abhängt und auch um Größenordnungen geringer sein kann als in Metallen, wird das Material als Halbleiter bezeichnet. Durch Dotierung mit z. B. Indium, welches gierig Elektronen „aufsaugt“, entsteht ein Überschuss an positiv geladenen Atomkernen (quasi ein Elektronenmangel) und man erhält einen p-Halbleiter.

Fügt man p- und n-Halbleiter zusammen, entsteht an der Berührungsfläche eine Grenzschicht. Die nach Elektronen hungernden p-Atomkerne saugen die Elektronen aus der benachbarten n-Schicht. Wenn alle freien Ladungsträger (Elektronen) abgewandert sind, kann kein Strom mehr fließen. Die Grenzschicht wird zur Sperrschicht. Doch wenn man den p-Halbleiter mit dem Pluspol einer Spannungsquelle verbindet und den n-Halbleiter mit dem Minuspol, fließen massenhaft Ladungen in den Kristall. Die Grenzschicht wird mit Ladungsträgern überschwemmt, und dadurch kann Strom fließen.

Polt man die Spannungsquelle um, werden die Ladungsträger abgesaugt. Die Sperrschicht wird größer als im spannungslosen Zustand. Es kann kein Strom fließen.

Ein Bauteil, welches den Strom nur in einer Richtung durchlässt, nennt man Diode oder Gleichrichter.

Transistoren

Das wichtigste Halbleiterbauelement ist der Transistor. Er besteht aus drei Lagen unterschiedlicher Halbleiterschichten. Je nach Reihenfolge der Schichten gibt es pnp- oder npn-Transistoren. Die äußeren Schichten heißen Emitter und Kollektor, die dünnere Sperrschicht zwischen ihnen (unterschiedlich, bis zu wenigen Atomen, dick) heißt Basis. Im stromlosen Transistor „saugen“ Kollektor und Emitter die Ladungsträger aus der Basis heraus und die Basis wird zur Sperrschicht. Der Transistor ist „gesperrt“, und zwischen Emitter und Kollektor fließt nur ein winziger „Reststrom“.

Es wird nur ein sehr kleiner Basisstrom benötigt, um die Basisschicht mit Elektronen zu füllen, denn weniger als ein Millionstel der Atome „hungern“ nach einem Elektron. Sobald ein kleiner Eingangsstrom in den Basis-Anschluss geleitet wird, entsteht dort ein Ladungsträgerüberschuss, der die Basisschicht zum Leiter macht („öffnet“). Dadurch kann ein wesentlich größerer Ausgangsstrom zwischen Emitter und Kollektor fließen. Das Verhältnis vom Ausgangsstrom zum Basis-Steuerstrom ist der „Stromverstärkungsfaktor“, der meist größer als 100 ist.

Anfangs konnte auf jedem Stück Halbleiter nur ein Transistor untergebracht werden. Später gelang es, Widerstände und Kondensatoren aus Halbleitermaterial zu fertigen und zusammen mit dem Transistor auf dem Halbleiterstück unterzubringen. Weitere Miniaturisierung ermöglichte eine wachsende Anzahl von Bauelementen pro Halbleiter.

Ein integrierter Schaltkreis (Mikrochip, engl. integrated circuit, abgekürzt IC) ist eine elektronische Schaltung, die auf einem einzelnen Halbleiterstück untergebracht ist. Weil Halbleiter empfindlich auf Sauerstoff, Licht und Schmutz reagieren und die Anschlüsse an die Pins extrem empfindlich sind, werden sie in einem vergossenen Gehäuse untergebracht.

Ein Prozessor ist ein integrierter Schaltkreis, der einige hundert Millionen Transistoren enthält.

Binärzahlen

Was ist das eigentlich – ein Zahlensystem?

Ein Zahlensystem dient dazu, Zahlen – vor allem große Zahlen – einfach und übersichtlich darzustellen. Außerdem soll es möglichst einfach sein, mit den Zahlen zu rechnen.

Mit dem Wachstum der ersten Städte und Zivilisationen entstand die Notwendigkeit, mit großen Zahlen umzugehen. Auf einem Bierdeckel mit ein paar Strichen die Anzahl der bestellten Biere zu notieren, ist übersichtlich. Mit 300 Strichen zu notieren, dass ein Einwohner mit 300 Krügen Wein seine Steuern bezahlt hat, ist sehr unübersichtlich. Deshalb wurden die ersten Zahlensysteme erfunden: Das sumerische, das ägyptische und später das römische Zahlsystem. Die Grundidee: Für größere Mengen von Einsen werden Gruppensymbole eingeführt. Die Römer verwendeten den Buchstabe „I“ für die Eins. Zehn Striche wurden durch ein „X“ ersetzt, „C“ steht für hundert und „M“ für tausend. Zusätzlich gibt es Halbzahlen: „V“ für fünf, „L“ für 50 und „D“ für 500. So konnte man die 300 Striche durch „CCC“ ersetzen. „MCCXIII“ bedeutet also 1213. Die Zahl 132 kann man als CXXXII, IIXXXC, XCXIIX oder XXXIIC schreiben. Die Reihenfolge der Ziffern spielt eigentlich keine Rolle, nur die Summe zählt. Daher werden derartige Zahlensysteme als „Additionssysteme“ bezeichnet.

Eine beliebige Reihenfolge der Ziffern führt allerdings dazu, dass es für eine Zahl viele verschiedene Schreibweisen gibt. Das ist unübersichtlich. Deshalb hatten die Römer eine Regel, die größeren Ziffern vor den kleineren zu schreiben.

Für die römischen Zahlen gibt es eine weitere, etwas merkwürdige Sonderregelung, um das Schreiben von vier gleichen aufeinander folgenden Zeichen zu vermeiden: Steht vor einer größeren Ziffer eine kleinere, wird die kleine von der großen abgezogen. Die Zahlen werden dadurch kürzer. So schreibt man für die Zahl 49 beispielsweise „XLIX“ ((50 minus 10) plus (10 minus 1)) statt „XXXXVIIII“. Zahl richtig falsch 4 IV IIII 9 IX VIIII 19 XIX XVIIII 1959 MCMLIX MDCCCCLVIIII

Die Addition und Subtraktion römischer Zahlen ist nicht leicht, gemessen an unserem heutigen Kenntnissen und Gewohnheiten. Sie zu multiplizieren, zu dividieren oder gar zu potenzieren ist ein Albtraum. Das dürfte ein wesentlicher Grund sein, warum von den Römern keine Entdeckungen auf den Gebieten Mathematik, Physik und Astronomie bekannt sind.

Die Inder haben das Dezimalsystem erfunden und die Araber haben es im 13. Jahrhundert nach Europa gebracht. Durch die Rechenbücher von Adam Ries wurde es in Deutschland bekannt. Dieses System vereinfachte das Rechnen sehr.

Stelle 2 1 0 Stellenwert 102 101 100 Beispiel 3 3 3 = 3*102 3*101 3*100 = 3*100 3*10 3*1

Durch welche Besonderheiten ist das Dezimalsystem den römischen Zahlen überlegen?

Das Dezimalsystem ist ein Stellenwertsystem mit zehn Ziffern. Alle Zahlen, klein oder beliebig groß, können mit zehn Ziffern (den Ziffern von 0 bis 9) gebildet werden. Zehn Ziffern = Dezimal.

mit zehn Ziffern. Alle Zahlen, klein oder beliebig groß, können mit zehn Ziffern (den Ziffern von 0 bis 9) gebildet werden. Zehn Ziffern = Dezimal. Das Dezimalsystem ist ein „Stellenwertsystem“: Der „Wert“ einer Ziffer hängt davon ab, an welcher Stelle einer Zahl sie steht. Wenn eine Ziffer von der letzten Stelle in die vorletzte Stelle einer Zahl vorrückt (wenn man z. B. rechts eine Null anfügt), ist sie zehn mal mehr „wert“. In der Zahl „333“ kommt die Ziffer 3 dreimal vor, wobei sie drei verschiedene Bedeutungen hat: Dreihundert, dreißig und drei.

Für das Rechnen mit großen Zahlen gibt es „relativ einfache“ Regeln. Ob ich mit zweistelligen oder 20stelligen Zahlen rechne, die Regeln sind dieselben.

Stelle 2 1 0 Stellenwert 22 21 20 Beispiel 1 1 0 = 1*22 1*21 0*20 = 1*4 1*2 0*1

Wir verwenden das Zehnersystem, weil wir Dinge an zehn Fingern abzählen. Hätten die Menschen einen weniger beweglichen Daumen, würden wir möglicherweise das Achter-System (Oktalsystem) für das natürlichste Zahlensystem der Welt halten. Wenn wir leicht bewegliche Zehen hätten und barfuß laufen würden, wäre vielleicht das Zwanziger-Zahlensystem optimal. Die Maya und die Azteken hatten es, und einige isolierte Naturvölker benutzen es heute noch.

Für Computer wird ebenfalls ein Stellenwertsystem benutzt, in dem es nur zwei Ziffern gibt, die Null und die Eins. Die Zwei und alle größeren Zahlen muss der PC aus Nullen und Einsen zusammenstellen. Dieses „binäre Zahlensystem“, auch „Dualsystem“ genannt, wurde von Leibniz erfunden. Der Name kommt aus dem lateinischen: bina = paarweise, duo = zwei. So hat z. B. die binäre Zahl "110" im dezimalen System den Wert 6.

Wie rechnet man im Binärsystem? Ganz einfach: Ob es sich um die Regeln für Addition, Multiplikation, Division und andere handelt, alle uns bekannten Rechenregeln sind für alle Stellenwert-Zahlensysteme identisch! Nur der Übertrag bei der Addition erfolgt nicht wie gewohnt nach der Neun, sondern nach der Eins.

Dezimal Dual Hex. 0 0 0 1 1 1 2 10 2 3 11 3 4 100 4 5 101 5 6 110 6 7 111 7 8 1000 8 9 1001 9 10 1010 A 11 1011 B 12 1100 C 13 1101 D 14 1110 E 15 1111 F 16 1 0000 10 17 1 0001 11 18 1 0010 12 19 1 0011 13 20 1 0100 14 21 1 0101 15 22 1 0110 16 23 1 0111 17 24 1 1000 18 25 1 1001 19 26 1 1010 1A 27 1 1011 1B 28 1 1100 1C 29 1 1101 1D 30 1 1110 1E 31 1 1111 1F 32 10 0000 20 33 10 0001 21 34 10 0010 22 35 10 0011 23 36 10 0100 24 37 10 0101 25 38 10 0110 26

Warum benutzen Computer nicht das Dezimalsystem?

Es gibt zwei Möglichkeiten, Ziffern elektrisch darzustellen. Die eine kennen Sie von alten Telefonen mit Wählscheibe. Wenn man die Neun wählt, werden neun Impulse zur Vermittlungsstelle geschickt, die einen Drehwähler um neun Schritte drehen.

Die andere Möglichkeit ist, Ziffern durch unterschiedlich hohe Spannungen darzustellen. Würde man unser gebräuchliches Dezimalsystem für Computer verwenden wollen, müsste man jede der zehn Ziffern durch einen anderen Spannungswert darstellen, z. B. Ziffer 0 durch 0 Volt, Ziffer 1 durch 0,3 V, Ziffer 2 durch 0,6 V, Ziffer 3 durch 0,9 V usw. bis zur Ziffer 9 mit 2,7 V. Diese Spannungen müssten sehr genau eingehalten werden, um sie unterscheiden zu können. Nehmen wir als Beispiel die Ziffer 2 mit 0,6 Volt. Schon eine geringe Abweichung von 5% = 0,15 Volt (5 % von 3 Volt, dem Maximalwert) würde den Pegel auf 0,75 Volt anheben. Dieser Wert wäre von der "Zwei" genau so weit wie von der "Drei" entfernt. Die Elektronik könnte nicht mehr zwischen benachbarten Ziffern unterscheiden.

Ist diese Genauigkeit von deutlich weniger als 5% überhaupt möglich?

Das erste Hindernis ist die extreme Temperaturempfindlichkeit aller Halbleiter. Sie erwärmen sich, wenn Strom hindurchfließt. Zehn Grad Temperaturerhöhung kann die Zahl der freien Ladungsträger verdoppeln. Damit steigt die Stromstärke und der Halbleiter wird immer wärmer, wenn der Strom nicht begrenzt wird, z. B. mit einem Widerstand.

Das zweite Problem ist die Nichtlinearität aller Halbleiterelemente. Wenn man die Eingangsspannung von Null beginnend allmählich erhöht, würde bei einem Bauelement mit linearer Kennlinie der Strom proportional zunehmen. Doch bei einem Transistor fließt noch kein Strom, bis die Eingangsspannung etwa 0,5 Volt erreicht hat. Ob die Spannung 0 Volt oder 0,3 oder 0,5 Volt beträgt, der Ausgangsstrom bleibt auf Null!

Im Bereich von 1,5 bis 3 Volt hängt der Ausgangsstrom fast linear von der Eingangsspannung ab. Steigt die Eingangsspannung weiter, gerät der Transistor in die „Sättigung“: Egal wie weit man die Eingangsspannung erhöht, der Ausgangsstrom steigt nicht mehr.

Mit so einem Bauelement kann man also zehn Ziffern nicht genau genug unterscheiden.

Das dritte Problem sind die großen Toleranzen bei der Herstellung. Winzigste Schwankungen in der Materialqualität und den Fertigungsbedingungen führen zu großen Abweichungen vom Durchschnitt. Betrachten wir als Beispiel ein einfaches Halbleiterelement: Den Transistor. Hochintegrierte Schaltungen enthalten Millionen Transistoren, da müsste es doch möglich sein, einen einzelnen Transistor „nach Maß“ zu fertigen? Weit gefehlt. Der Transistor BC 546 beispielsweise wird seit Jahrzehnten von zahlreichen Firmen als Massenprodukt gefertigt.

Transistor-Stromverstärkungsklassen Gruppe A Gruppe B Gruppe C 110 ... 220 220 ... 450 420 ... 800

Allerdings schafft es noch immer keiner der Hersteller, Transistoren genau mit den gewünschten Eigenschaften herzustellen. Angenommen, ein Hersteller bekommt eine Bestellung über 10 000 Transistoren mit einer Stromverstärkung zwischen 220 und 450. Er wird etwa 20 000 Stück produzieren und sie in der Gütekontrolle in die Gruppe A, B und C einsortieren. Beachten Sie die gewaltige Streuung des Stromverstärkungsfaktors von 110 bis 800! Der Kunde wird mit den Transistoren aus Gruppe B beliefert. Und der Rest? Der geht ins Lager. Bei entsprechender Preisgestaltung wird sich das meiste verkaufen lassen.

Stellen Sie sich eine Autofabrik vor, wo Autos unterschiedlicher Qualität vom selben Fließband rollen: PKW mit einem Verbrauch von 30 Liter/100 km und 50 km/h Höchstgeschwindigkeit, und eine Stunde später mit 8 Liter/100 km und 300 km/h Höchstgeschwindigkeit. In der Gütekontrolle würden die Autos sortiert und in mehrere Klassen eingeteilt, die dann zu verschiedenen Preisen verkauft werden. Autos mit einem Verbrauch über 20 Litern oder einer Höchstgeschwindigkeit unter 60 km/h werden verschrottet. Nun, vielleicht habe ich ein wenig übertrieben, jedenfalls würden sich die Autobauer unter Ihnen schon bei viel kleineren Qualitätsunterschieden in Grund und Boden schämen. Doch so verfährt die Halbleiterindustrie mit ihren Erzeugnissen.

Wenn es schon bei einem simplen Transistor nicht gelingt, ihn „nach Maß“ herzustellen – wieviel schwerer ist es dann, einen Prozessor mit hunderten Millionen Transistoren mit genau den gewünschten Eigenschaften zu produzieren? Es gelingt nicht. Der Ausschuss steigt exponentiell mit der Größe des Chips. Bei der Einführung einer neuen Produktgeneration kann anfangs deutlich mehr als die Hälfte der Produktion unbrauchbar sein. Auch die brauchbaren CPUs unterscheiden sich. Wenn sie die gleiche Berechnung durchführen, werden sie unterschiedlich heiß. Wenn der Prozessor bei der geplanten Frequenz zu heiß wird, bekommt er eine niedrigere Taktfrequenz aufgedruckt, denn die Wärmeentwicklung ist etwa proportional zur Taktfrequenz. Stromsparende Exemplare, die besonders „cool“ bleiben, werden etwas teurer verkauft und vielleicht in Premium-Notebooks verbaut.

Um auf die Frage zurückzukommen, ob eine Genauigkeit von deutlich weniger als 5% überhaupt möglich ist: Ja, unter den zehntausenden Transistoren könnte man einige wenige finden, die genau genug wären. Allerdings wäre die Ausbeute extrem niedrig und demzufolge der Preis hoch. Bezahlbare Computer könnte man so nicht bauen.

Wenn allerdings ein Transistor nicht zehn, sondern nur zwei Zustände unterscheiden braucht, vereinfacht das die Konstruktion eines Computers enorm. Die zwei Zustände „gesperrt“ und „geöffnet“ beherrscht jeder Transistor.

Ist es aber möglich, statt mit zehn Ziffern mit zwei Ziffern auszukommen?

Das Dualsystem

Das Dualsystem ist ein Zahlensystem, das mit zwei Ziffern auskommt: Null und Eins. Das macht es fehlerresistent. Da die Elektronik nur zwei Zustände zu unterscheiden braucht, sind auch nichtlineare Elemente mit schwankenden Parametern geeignet.

Bei einer Betriebsspannung von 3 Volt gilt meist eine Eingangsspannung zwischen 0 V und 0,8 V als Ziffer 0, und eine Eingangsspannung über 2,0 V gilt als Ziffer 1. Eingangsspannungen zwischen 0,8 V und 2,0 V sind undefiniert und dürfen nicht auftreten.

In jedem Schaltkreis werden die Signale regeneriert: Die Ausgänge eines Schaltkreises liefern 0,4 V bei der Ziffer 0. Selbst wenn diese Spannung von Null bis 0,8 V schwankt, und wird sie trotzdem von der nachfolgenden Schaltung einwandfrei als Null erkannt. Die 2,4 V Ausgangsspannung der Ziffer 1 darf von 2,0 bis 3,0 Volt schwanken. Durch diese großzügigen Toleranzen bei den zulässigen Eingangsspannungen wird eine hohe Zuverlässigkeit erreicht. Die genauen Spannungen variieren je nach Herstellungstechnologie (TTL, CMOS, Schottky oder andere) und sind Datenblättern zu entnehmen.

Fazit: Nur auf der Basis des binären Zahlensystems kann man bezahlbare Computer bauen, und deshalb müssen wir uns hier mit dem Binärsystem herumschlagen. Erst durch die Reduzierung aller Schaltelemente auf nur noch zwei Spannungsstufen konnten die Toleranzanforderungen an die elektronischen Bauelemente so sehr verringert werden, dass die preiswerte Massenfertigung von Schaltkreisen möglich wurde. Weil wir preiswerte Computer wollen, müssen wir die Unannehmlichkeit in Kauf nehmen, dass die Computer nur Nullen und Einsen kennen und jede, absolut jede Information (Zahlen, Texte, Bilder, Musik, Videos, ...) in eine Folge von Nullen und Einsen umgewandelt werden muss.

Binärzahlen sind allerdings sehr lang und unübersichtlich. Die vierstellige Dezimalzahl 1234 wird im Binärsystem zur 11-stelligen 100 1101 0010. Die Anzahl der Binärstellen wird als „Bit“ bezeichnet, 100 1101 0010 ist also eine 11-Bit-Binärzahl. Ein anderes Beispiel: Die Zahl 1 000 000 wird zu 1111 0100 0010 0100 0000, einer 20-Bit-Zahl. Jeweils 8 Bit werden zu einem Byte zusammengefasst.

Programmierer haben oft mit 32-Bit-Zahlen (4 Byte) zu tun. Ein Beispiel: 0000 0000 0000 0000 1111 1111 1111 0000 ist die Adresse, mit der das BIOS-Programm beginnt. Können Sie sich so eine Zahl merken oder sie wenigstens fehlerfrei abschreiben? Das ist schwierig. Deshalb benutzen Programmierer aushilfsweise das Hexadezimalsystem.

Das Hexadezimalsystem

Das lateinische Wort „Hexadezimal“ bedeutet „Sechzehn“. Es handelt sich also um ein Zahlensystem mit 16 Ziffern. Mit den Ziffern 0 bis 9 hat man aber nur 10 Ziffern zur Verfügung. Um nicht sechs weitere Ziffernsymbole neu erfinden zu müssen (und weltweit neue Computertastaturen mit sechs zusätzlichen Tasten einführen zu müssen), verwendet man die Zeichen A, B, C, D, E und F als Ziffern. Zählen wir einmal im Hexadezimalsystem, beginnend mit der Ziffer Null:

0, 1, 2, 3, 4, 5, 6, 7, 8, 9, A, B, C, D, E, F, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 1A, 1B, 1C, 1D, 1E, 1F, 20, 21, 22 usw. Nach der 79 kommt 7A, 7B, 7C, 7D, 7E, 7F, 80. Nach AE kommt AF und B0, nach FE kommt FF, 100 und 101. Alles klar?

Wie wandelt man Binärzahlen in Hexadezimalzahlen um und umgekehrt? Nehmen wir das Beispiel mit der Darstellung einer Million.

Binär 1111 0100 0010 0100 0000 Hexadezimal F 4 2 4 0

Die Umrechnung von Binärzahlen in Hexadezimalzahlen ist ganz leicht. Man unterteilt die Binärzahl von Rechts beginnend in Vierergruppen und ersetzt jede Vierergruppe durch eine Hexadezimalziffer. So hat eine Hexadezimalzahl viermal weniger Stellen als die gleiche Binärzahl. Das ist der Vorteil des Hexadezimalsystems: Große Zahlen werden kompakt dargestellt und man kann sie sich besser merken.

ASCII-Tabelle (Auszug) Zeichen dezimal binär 0 48 110000 1 49 110001 2 50 110010 ... 9 57 111001 : 58 111010 ; 59 111011 < 60 111100 = 61 111101 > 62 111110 ? 63 111111 @ 64 1000000 A 65 1000001 B 66 1000010 C 67 1000011 D 68 1000100 ... a 97 1100001 b 98 1100010 c 99 1100011

Wie kann der PC Buchstaben und Zahlen darstellen?

Um Texte zu schreiben, benutzen wir ein Alphabet aus einigen Dutzend Buchstaben sowie zahlreiche Sonderzeichen. Für Zahlen haben wir zehn Ziffern zur Verfügung. Das „Alphabet“ des Computers besteht aber nur aus zwei Zeichen: Eins und Null. Wie kann man damit auskommen?

Die Methode ist einfach und wurde schon vor langer Zeit erfunden. Denken Sie bitte mal an das Morsealphabet: Es gibt kurze und lange Zeichen („Punkt“ und „Strich“) sowie Pausen zwischen den Zeichen. In der Morsecode-Tabelle ist jedem Buchstaben eine Kombination von Punkten und Strichen zugeordnet. Eine ähnliche Codetabelle gibt es auch für die Darstellung von Buchstaben im Computer.

ASCII und das Byte

Eine der gebräuchlichsten Code-Tabellen für Computer ist ASCII, was für „American Standard Code for Information Interchange“ steht. In dieser Tabelle sind alle wichtigen Zeichen der englischen Sprache aufgezählt und von Null bis 127 durchnummeriert. So hat beispielsweise der Buchstabe „A“ die Nummer 65 (binär: 100 0001), „B“ die 66 (binär: 100 0010) usw. Auch die Zeichen für die Ziffern haben eine Nummer: die Ziffer „1“ hat die Nummer 49 (binär: 11 0001). Auch „nicht druckbare“ Zeichen haben eine Nummer bekommen, zum Beispiel die Taste „Enter“ die Nummer 13 (binär: 0000 1101) und die Löschtaste „Rückschritt“ (Backspace) die 8 (0000 1000). In der nebenstehenden Tabelle sind einige Werte aufgeführt.

ASCII-Tabelle Hier ist die vollständige

Ein Text im ASCII-Format enthält keine Formatierungen (Fett, Kursiv) oder Schriftarten. Wenn Sie den Editor aus der Zubehör-Programmgruppe verwenden oder eine Datei in MS Word als „Nur-Text“ speichern, wird ASCII verwendet.

Nun gibt es zahlreiche Buchstaben in anderen Sprachen, die im englischen Alphabet nicht vorkommen. Für deutsche Texte beispielsweise braucht man die Umlaute sowie das „ß“. Für die ursprünglichen 127 Zeichen der einfachen ASCII-Tabelle wurden deshalb mehrere Erweiterungstabellen mit je 128 zusätzlichen Zeichen zusammengestellt. Die in Amerika, Mitteleuropa und Australien verbreitete Kodierung „Latin-1“ enthält deutsche Umlaute, französische Accent-Zeichen und spanische Zeichen mit Tilde. Dazu kommen diverse kaufmännische und wissenschaftliche Zeichen. Weitere Erweiterungstabellen gibt es für griechische, slawische, nordische und einige andere Sprachen. Das „American National Standards Institute“ (das amerikanische Pendant zum DIN, dem Deutschen Institut für Normung) hat den einfachen und den erweiterten ASCII-Zeichensatz unter dem Namen „ANSI-Zeichensatz“ zusammengefasst.

Unicode

Nun reichen auch 256 Zeichen noch nicht für alle Sprachen aus. Japaner, Chinesen und zahlreiche andere Völker mit nicht-lateinischen Schriftzeichen waren benachteiligt und forderten eine praktikable Möglichkeit, die vielen Zeichen ihrer Sprache genau so selbstverständlich benutzen zu dürfen, wie wir das lateinische Alphabet am Computer benutzen. Deshalb entwickelten die Computerfachleute eine Codierung namens Unicode, mit der man alle jemals von Menschen verwendeten Schriftzeichen speichern kann, einschließlich sumerischer Keilschrift, ägyptischer Hieroglyphen und weiterer Schriftzeichen, die vielleicht zukünftig entdeckt werden. Unicode kann derzeit über 1,1 Millionen unterschiedliche Zeichen darstellen. Je nachdem, welches der vielen Zeichen man darstellen möchte, braucht man dafür 1 bis 4 Byte. Unsere lateinischen Buchstaben werden wie im ASCII-Standard mit einem Byte kodiert. Einige Zeichen der erweiterten ASCII-Tabelle verweisen auf eine der vielen Tabellen mit weiteren Zeichen. MS-Office, OpenOffice und die meisten anderen modernen Schreibprogramme erkennen automatisch, ob ein Text in ASCII oder in Unicode gespeichert ist.

Zentraleinheit

Der erste Universalcomputer „Z3“ wurde 1941 von Konrad Zuse gebaut. „Universal“ deshalb, weil er „frei programmierbar“ war (d. h. beliebige Programme ausführen konnte). Der Computer Z3 rechnete digital mit 22 Stellen, bestand aus 2600 Relais und konnte 20 Befehle pro Sekunde ausführen.

Ohne von Zuse zu wissen, entwickelte Howard Aiken (USA) im Jahr 1944 aus 3500 Relais und 2225 Fernsprechzählern den „Mark I“. Er war in eine Schrankwand von 15 Meter Länge und 2,5 Meter Höhe eingebaut. Mark I benutzte das Dezimalsystem. Der Computer benötigte 0,3 Sekunden für eine Addition und 6 Sekunden pro Multiplikation. Gebaut wurde er vom Büromaschinenkonzern IBM in einer kleinen Serie für die US-Navy. Seine technischen Daten sollen Thomas Watson, Präsident von IBM, zu der Äußerung veranlasst haben: „Ich glaube, es gibt einen Weltmarkt für vielleicht fünf Computer.“ Nun, bei einem Stückpreis von einer halben Million Dollar und 5 Tonnen Gewicht war Mark I offensichtlich kein Kandidat für eine Massenproduktion ...

1946 ging in den USA der „ENIAC“ (electronic numerical integrator and calculator) in Betrieb. Mit seinen 18 000 Elektronenröhren war er der erste vollelektronische Computer. Er schaffte 35 Multiplikationen pro Sekunde, fast das Doppelte wie der Z3. Angeblich war der ENIAC die Hälfte der Zeit wegen Wartungsarbeiten außer Betrieb – kein Wunder bei den damals noch sehr anfälligen Elektronenröhren. Jeden Monat wurden 2000 Elektronenröhren prophylaktisch ausgewechselt.

1981 begann IBM mit der Serienproduktion des „Personal Computers“. Dessen Erfolg veranlasste zahlreiche Firmen, „kompatible“ Computer zu entwickeln. Hardware-kompatibel bedeutet, dass Tastaturen, Drucker, RAM, Laufwerke, Bildschirme und andere Komponenten verschiedener Hersteller untereinander austauschbar sind. Software-Kompatibilität bedeutet, dass ein Programm auf Computern unterschiedlicher Hersteller funktioniert, ohne dass irgendwelche Anpassungen nötig sind.

Für Wetterprognosen, Klimasimulationen, Erdbebenvorhersagen und Crashtests werden Supercomputer mit gewaltigen Rechenleistungen eingesetzt. Pharmazie, Genforschung, theoretische Chemie, Astrophysik und viele andere Forschungen kommen nicht ohne Supercomputer aus. Der IBM-Supercomputer Deep Blue mit 256 CPUs hat 1997 um die Krone des Schachweltmeisters gekämpft und mit 3,5 zu 2,5 Punkten gewonnen.

Im Jahr 2012 wurde der „JUQUEEN“ in Deutschland im Forschungszentrum Jülich in Betrieb genommen. Damals belegte er Platz 8 der „Weltbestenliste“ und war der leistungsstärkste Computer Europas. JUQUEEN bestand aus 72 Schränken mit 458 752 Prozessorkernen (28 672 Prozessoren mit je 16 Kernen) und 448 000 Gigabyte Arbeitsspeicher. Nach sechs Jahren wurde er im Mai 2018 abgeschaltet und durch den leistungsstärkeren „JUWELS“ ersetzt. Inzwischen ist der SuperMUC NG im Leibnitz-Rechenzentrum in München ist mit 6480 CPUs mit je 48 Kernen der leistungsstärkste Rechner Deutschlands und der EU.

Der drittschnellste Computer ist der chinesische „Sunway TaihuLight“ mit knapp elf Millionen Kernen (40960 CPUs mit je 260 Prozessorkernen) und 1,3 Petabyte (Millionen Gigabyte) Arbeitsspeicher.

Der zweitschnellste Computer der Welt ist der „Sierra“ im Lawrence Livermore National Laboratory (USA), der mit CPUs vom Typ „IBM Power9“ arbeitet. Jede dieser CPUs hat 22 Kerne.

Der weltschnellste Computer im Juni 2019 ist „Summit“ im Oak Ridge National Laboratory (USA). Die Rechenleistung erbringen gemeinsam 9216 POWER9 CPUs (mit je 22 Kernen) und 27 648 Nvidia Tesla Grafikprozessoren. Mit 10 Petabyte Arbeitsspeicher (1017 Byte) belegt der Computer eine Fläche von 520 Quadratmetern. Der „Summit“ braucht 13 MW Energie, das ist der Bedarf von 100 000 Haushalten.

Ein moderner Supercomputer kostet gegenwärtig eine halbe Milliarde Euro. Etwas „preiswerter“ sind Großrechner, sogenannte „Mainframes“. Sie kosten von 0,5 bis 50 Millionen Euro. Wegen ihrer bemerkenswert hohen Zuverlässigkeit werden sie in den Rechenzentren von Universitäten, Verwaltungen und Großfirmen eingesetzt, beispielsweise für Flugreservierungssysteme.

EDV-Anlagen der „mittleren Datentechnik“ werden von mittelständischen Unternehmen und großen Konstruktionsbüros eingesetzt. Der bedeutendste Anbieter ist IBM mit dem System „AS/400“. Dieses System ist „skalierbar“, d. h. man kann zunächst ein 5-Benutzer-System mit zwei „Power-PC-Prozessoren“ kaufen und es schrittweise bis zu einem System mit dutzenden CPUs für tausend Benutzer erweitern, wenn die Firma wächst.

Bei der AS/400 sind Hard- und Software durch eine „Isolationsschicht“ getrennt. Diese Isolationsschicht ermöglicht es den Anwendern seit zwanzig Jahren, die Hardware zu modernisieren oder auszuwechseln, ohne dass irgendeine Änderung an der Software nötig ist – und umgekehrt. Auf einer AS/400-Anlage können gleichzeitig Windows (in verschiedenen Versionen), Linux, Unix und andere Programme laufen. Die Zuverlässigkeit ist beeindruckend. Allerdings kostet so ein System etwa ein- bis dreihunderttausend Euro.

„Workstations“ sind im Leistungsbereich zwischen der mittleren Datentechnik und einem „gewöhnlichen“ PC angesiedelt. Oft sind mehrere Prozessoren eingebaut, jeder mit mehreren Prozessorkernen. Workstations werden vorzugsweise für CAD-Systeme und für wissenschaftlich-technische Berechnungen eingesetzt. Die Zuverlässigkeit der Hardware übertrifft einen PC um Größenordnungen. Als Betriebssystem werden vorzugsweise Unix- und Linuxsysteme eingesetzt. Die Bedeutung von Workstations hat im letzten Jahrzehnt abgenommen, weil sehr gut ausgestattete PC sich der Leistung von Workstations annähern.

In diesem Buch geht es nur um einen einzigen Typ von Computern, der normalerweise nur einen einzigen Prozessor enthält: Um den Personal Computer, abgekürzt „PC“. Von allen bezahlbaren Computern ist es der Typ mit den vielseitigsten Verwendungsmöglichkeiten. Der „PC“ wird volkstümlich meist als Computer bezeichnet, auch in diesem Buch.

Ende 2008 gab es immerhin schon eine Milliarde PCs. Dazu kommen die 300 000 Server von Microsoft, 100 000 Server der Firma Intel und die 70 000, die der Internet-Provider 1&1 betreibt. Es wird geschätzt, dass Google eine Million Server benutzt [1] und dass jedes Quartal 100 000 dazukommen. Wenn man noch die Playstations von Sony, die Wii von Nitendo und die X-Box von Microsoft dazurechnet (das sind Spielcomputer mit einer ähnlichen Leistung wie ein PC) sowie „Embedded Computer“ (eingebettete, integrierte Computer, die in Handys, Waschmaschinen, Autos und Werkzeugmaschinen stecken), gab es schon gegen Ende des letzten Jahrhunderts viel mehr Computer als Menschen. Seitdem sind Milliarden Smartphones und Tablets dazugekommen. Wikimedia betreibt insgesamt 378 Server (2012).

Hauptkomponenten eines PC

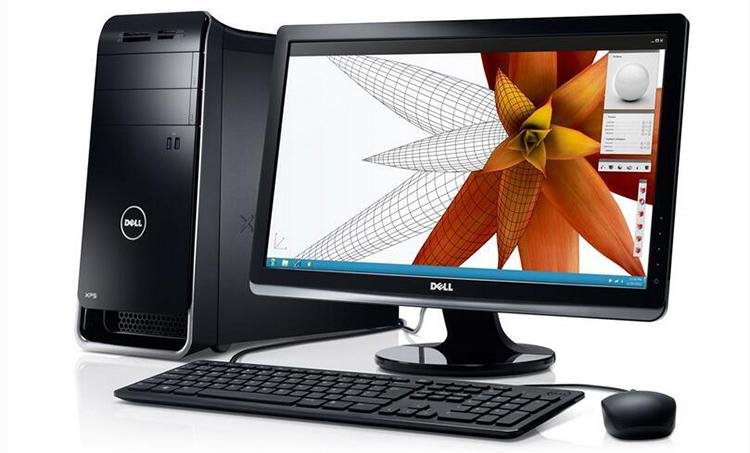

Der wichtigste und meist auch teuerste Teil eines PC-Systems ist die graue Kiste, die als Systemeinheit oder Grundgerät bezeichnet wird. Auf dem Foto „Hauptkomponenten eines PC“ sehen Sie, welche Teile unbedingt zu einem PC gehören:

Das Gehäuse mit Netzteil und Zusatzlüftern,

die Hauptplatine mit Prozessor und RAM-Speicher sowie vielen Anschlusssteckern innen und außen für weitere Hardware,

die Festplatte

Früher oft ein Diskettenlaufwerk,

ein DVD-Laufwerk und

weitere Komponenten, zum Beispiel Soundkarte Fernsehkarte Netzwerkkarte

Im Bild rechts oben sind diese Teile in ein Gehäuse gezwängt, das durch die „herumhängenden“ Kabel recht unübersichtlich aussieht. Unterhalb des Netzteils, links neben dem RAM-Modul sehen Sie einen großen Lüfter. Darunter ist der Prozessor versteckt.

An die Systemeinheit werden Peripherie-Geräte angesteckt, meist an der Rückseite.

Zu den Eingabegeräten zählen unter anderem Tastatur, Maus und Scanner

Zu den Ausgabegeräten zählen unter anderem Bildschirm, Drucker und Plotter

Zu den Speichergeräten zählen unter anderem externe Festplatten, Brenner, Kamera-Speicherkarten und USB-Sticks.

-

Der Prozessor

Intel Pentium II-Prozessor

Die „Central Processing Unit“ (CPU), deutsch: Zentrale Verarbeitungseinheit, kurz: Prozessor, ist die oberste Steuerung für den PC. Die CPU führt Berechnungen aus und steuert alle Komponenten des PC. Keine Mausbewegung, keine Tastenbetätigung, kein Byte, das aus dem Internet eintrifft - nichts darf der CPU entgehen. Leistung und Qualität der CPU sind daher entscheidend für die zuverlässige Funktion des ganzen Computersystems.

Im Laufe der Jahrzehnte gab es zahlreiche Hersteller von CPUs: Intel, AMD, Motorola, Cyrix, IBM, IDT, NEC, SiS, UMC, VIA, ARM, Rockwell und andere. Die Firma Intel ist der Marktführer und bestimmt seit Jahrzehnten entscheidend die technologische Entwicklung. Die Firma AMD mit ihrem Athlon-Prozessor ist für Intel der wichtigste Konkurrent.

Jede Prozessorfamilie hat im Vergleich zur vorhergehenden Generation neue, erweiterte Eigenschaften und zusätzliche Befehle. Ein wichtiges Designkriterium ist die „Kompatibilität“: Jeder Prozessorhersteller achtet sorgfältig darauf, dass auf jeder neuen CPU alle Befehle ebenso funktionieren wie auf der Vorgänger-CPU. Dadurch läuft Ihre vertraute Software auf jedem neuen Prozessor. Allerdings braucht man für eine neue Generation von CPUs fast ausnahmslos eine neue Generation von Hauptplatinen.

Im Sommer 2018 ist der Core i9-7980X das „Flaggschiff“ von Intel. Es ist ein 18-Kern-Prozessor mit vier Speicherkanälen und einem Takt von 3,3 GHz, der im Turbo-Modus auf 4,5 GHz steigt. Er kostete anfangs 2250 Euro. Einfachere Modelle aus der Core i3 Serie gibt es bereits ab 50 Euro.

In der nachfolgenden Tabelle sind wichtige historische Prozessorfamilien des Herstellers Intel, deren Taktfrequenzen und deren Bezeichnungen als Beispiel dafür aufgeführt, in welchen Schritten sich die Prozessortechnik entwickelt hat. Auf einen Vergleich konkreter aktueller Prozessoren von Intel, AMD und anderen Herstellern wird hier verzichtet, da die Entwicklung sehr schnell fortschreitet. Der Intel-Ingenieur Gordon Moore prognostizierte schon 1965, dass die Transistoranzahl in integrierten Schaltkreisen alle zwei Jahre verdoppelt werden kann. Die Presse nannte diese Regelmäßigkeit dann das Mooresche Gesetz. Es handelt sich dabei allerdings nicht um ein wissenschaftliches Naturgesetz, sondern um eine durch empirische Beobachtung begründete Faustregel, die auf langfristigen Planungen der Halbleiterindustrie beruht und die bis heute zutrifft.

1978 i8086 (PC XT) 4,77 MHz 29000 Transistoren 1982 i80286 (286er) 6 – 16 MHz 120000 Transistoren 1985 i80386 (386er) 16 – 33 MHz 275000 Transistoren 1991 i80486 (486er) 33 – 100 MHz 1,2 Mio. Transistoren 1993 Pentium 66 – 200 MHz 3,1 Mio. Transistoren 1997 Pentium MMX 166 – 233 MHz 4,5 Mio. Transistoren 1997 Pentium II 233 – 450 MHz 7,5 Mio. Transistoren 1999 Pentium III 333 – 1400 MHz 24 Mio. Transistoren 2000 Pentium 4 1400 – 3500 MHz 42 Mio. Transistoren 2006 Core Duo 1660 – 2160 MHz 151 Mio. Transistoren 2006 Core 2 Duo 1667 – 2333 MHz 291 Mio. Transistoren 2008 Core i3, i5, i7 1000 - 3200 MHz 1170 Mio. Transistoren 2011 Core i7-3960X 3300 - 3900 MHz 2270 Mio. Transistoren 2015 Core i7-5960X 3000 - 3500 MHz 2600 Mio. Transistoren 2017 Core i9-7900X 3300 - 4500 MHz 3500 Mio. Transistoren

Die Bestandteile der CPU

Das Rechenwerk (Arithmetic Logic Unit, ALU) führt die Berechnungen aus,

Die Steuereinheit (Control Unit, CU) entschlüsselt die Befehle,

Der Speichermanager (Memory Management Unit, MMU) verwaltet den Arbeitsspeicher,

Der mathematische Coprozessor (Float Point Unit, FPU) führt Gleitkommaberechnungen

Der CPU-Cache speichert häufig benötigte Daten.

Die Taktfrequenz

Gesetzliche Maßeinheiten 1 s = 1000 ms (Millisekunden) 1 ms = 1000 μs (Mikrosekunden) 1 μs = 1000 ns (Nanosekunden) 1 ns = 1000 ps (Pikosekunden)

Alle Vorgänge in einem Prozessor laufen getaktet, also synchron ab. Die Taktfrequenz gibt an, wie oft die Taktsignale erfolgen. Der erste IBM-PC mit dem Prozessor „i8088“ aus dem Jahr 1981 hatte eine Taktfrequenz von knapp 5 MHz (MHz = Megahertz = Millionen Takte pro Sekunde). Jeder Takt dauert also 200 ns (Nanosekunden). Jede einzelne Schaltung des i8088 war so entworfen, dass sie niemals länger als 200 ns für einen einfachen Befehl braucht. Anders ausgedrückt: Ein Prozessortakt ist die Zeit für die Ausführung eines einfachen Befehls, zum Beispiel einer Addition. Auch ein Speicherzugriff dauerte damals genau einen Takt. Heutige PCs haben Taktfrequenzen von drei bis vier Gigahertz (drei bis vier Milliarden Takte pro Sekunde).

Das ist allerdings eine vereinfachte Darstellung. Einige Befehle sind komplizierter auszuführen als andere und ihre Ausführung dauert deutlich länger. Nehmen wir als Beispiel die Division. Einerseits ist sie viel aufwändiger als eine Addition, andererseits kommt sie sehr selten vor. Die Taktfrequenz und damit die Rechengeschwindigkeit wurde so gewählt, dass die meisten Befehle während eines Taktes ausgeführt werden können. Aufwändigere Befehle bekommen als „Fristverlängerung“ einen zweiten, dritten oder weitere Takte genehmigt.

Es ist logisch, dass eine CPU mit einer höheren Taktfrequenz mehr Befehle pro Zeiteinheit ausführen kann. Deshalb wurde im Laufe der Jahre die Taktfrequenz der CPU schrittweise erhöht. Die Taktfrequenzen stiegen von anfangs 4,77 MHz (1981) auf 6, 8, 10 und 12 MHz. Immer neue CPUs wurden entwickelt. Es entbrannten regelrechte „Megahertz-Schlachten“ zwischen den Konkurrenten: Wer hat den schnellsten Prozessor? Etwa 1993 erreichten die Prozessoren eine Taktfrequenz von 100 MHz, was 10 ns pro Takt entspricht: Eine Steigerung auf das zwanzigfache in zwölf Jahren! Im Jahr 2002 waren 3000 MHz erreicht. Eine weitere Steigerung schien fast unmöglich, denn es wurde immer schwieriger, die CPUs ausreichend zu kühlen.

Einer der Auswege war das Hyper-Threading-Verfahren (HT), das im Jahr 2002 von Intel auf den Markt gebracht wurde. Ein „Thread“, übersetzt „Programmfaden“, ist ein kleiner Programmabschnitt, der unabhängig von anderen Threads ausgeführt werden kann. Wenn Sie z. B. von einem Rechteck die Fläche f = a × b und den Umfang u = 2 (a + b) berechnen müssen, hat es keinen Einfluss auf die Ergebnisse, in welcher Reihenfolge die Berechnungen ausgeführt werden. Wenn die CPU einen Programmfaden nicht weiter ausführen kann (z. B. weil das Heranschaffen von Daten aus dem Arbeitsspeicher noch ein Weilchen dauert), wechselt eine Hyper-Threading-fähige CPU einfach zur Abarbeitung eines anderen Programmfadens. Theoretisch verdoppelt sich die Leistung der CPU durch HT, realistisch ist ein Leistungszuwachs bis zu 33% ohne Erhöhung der Taktfrequenz.

Seit 2006 gibt es CPUs mit zwei Prozessorkernen in einem gemeinsamen Gehäuse. Der Intel Core 2 Quad mit vier Kernen ist seit Anfang 2007 erhältlich und die Intel Core i7 enthalten sechs, acht oder zehn Prozessorkerne, der Intel Core i9 sogar 18 Kerne. Einerseits kann mit der Mehrkerntechnologie der Energiebedarf der CPU und damit die Wärmeentwicklung drastisch reduziert werden, indem z. B. ungenutzte Funktionseinheiten und auch ganze Kerne zeitweilig abgeschaltet werden. Andererseits steigt die Rechenleistung drastisch an. Eine Acht-Kern-CPU mit 3 GHz Taktfrequenz, wobei jeder Kern Hyper-Threading beherrscht, kann (rein theoretisch) 8 × 3 × 2 = 48 Milliarden Befehle pro Sekunde ausführen! In der Liga der Hochleistungscomputer sind CPUs mit 12, 16, 57 oder 260 Kernen weit verbreitet.

Der RAM (Arbeitsspeicher) enthält die Daten und Befehle für die CPU. Seine Geschwindigkeit ist wichtig für die Leistung des Computers. Pro Befehl müssen durchschnittlich ein bis vier Datenbyte aus dem RAM gelesen werden, der Befehl selbst ist weitere ein bis vier Byte lang. Die RAM-Zugriffszeiten hatten sich von 120 ns (1981) auf 12 ns (1990) verringert. Während die Geschwindigkeit der CPUs auf das 20-fache stieg, wurde RAM „nur“ 10-mal schneller. Der RAM wurde zunehmend zur Bremse. Je schneller die CPUs wurden, desto öfter mussten sie für einige Takte pausieren (sogenannte Wartetakte einlegen, engl: „Waitstate“), um auf das Eintreffen der angeforderten Daten aus dem RAM zu warten. Was nun?

Es gibt bisher drei Lösungsmöglichkeiten, um den RAM-Engpass zu entschärfen: Bus-Breite, Parallelisierung und den Cache-Speicher. (Als „Bus“ werden die Datenleitungen im PC bezeichnet, mit denen große Datenmengen transportiert werden. Es gibt z. B. den PCI-Express-Bus, der die Steckplätze der Erweiterungskarten verbindet, und den Speicherbus, der die RAM-Steckplätze mit der CPU verbindet. 64 Datenleitungen, bis zu 40 Adressleitungen und einige Steuerleitungen bilden den Speicherbus.)

Der erste PC mit der i8088-CPU holte sich jedes Byte einzeln aus dem Speicher. Die i8086-CPU konnte bereits 16 Bit = 2 Byte parallel (d.h. gleichzeitig, in einem Lesevorgang) aus dem Speicher lesen. Die 286er und 386er Prozessoren arbeiteten mit 32 parallelen Bits (4 Byte), während die Pentium-CPUs 64 Bit = 8 Byte in einem Speichertakt lesen bzw. schreiben können.

(d.h. gleichzeitig, in einem Lesevorgang) aus dem Speicher lesen. Die 286er und 386er Prozessoren arbeiteten mit 32 parallelen Bits (4 Byte), während die Pentium-CPUs 64 Bit = 8 Byte in einem Speichertakt lesen bzw. schreiben können. Den Speicherbus von derzeit 8 Byte auf 16 Byte zu verbreitern wäre eine Möglichkeit, doch es würde sich nicht lohnen. Die CPU greift im ständigen Wechsel auf mindestens zwei Speicherbereiche zu: Daten und Programmcode. Es ist zu selten, dass die CPU mehr als acht unmittelbar aufeinanderfolgende Byte benötigt. Deshalb arbeiten moderne CPUs mit der Dual-, Triple- oder Quad-Channel-Technologie: Aus der CPU führen zwei, drei oder vier Speicherbusse zu den RAM-Steckplätzen. Während ein Speicherkanal noch mit Lesen oder Schreiben beschäftigt ist, kann die CPU weitere Anforderungen an die anderen Speicherkanäle richten. Der Hardware-Aufwand ist freilich groß. Für jeden Speicherbus müssen mehr als hundert Kontakte aus der CPU herausgeführt werden. Deshalb haben die Vier-Kanal-CPUs von Intel 2011 oder 2066 Pins („Beinchen“).

Die dritte Möglichkeit ist die Verwendung eines „Cache“-Speichers, sprich „Kesch“ oder „Käsch“. Der Prozessorcache ist ein kleiner schneller Speicher, der sich das Prozessorgehäuse mit der CPU teilt und die Arbeit der CPU wesentlich beschleunigt.

Turbo-Modus, Speedstep und die Wärmeentwicklung

Solange sich ein Computerschaltkreis im Zustand „0“ oder „1“ befindet, verbraucht er fast keinen Strom. Während des Umschaltens zwischen den Zuständen steigt der Strombedarf steil an. Je öfter die Umschaltung erfolgt (also je höher der Takt), desto höher ist die Wärmeentwicklung. Die leistungsschwache CPU „Pentium Dual-Core E2140“ beispielsweise braucht 42 Watt im Betrieb und nur 11 Watt im Leerlauf. Wenn sie von ihrer Nominalfrequenz von 1,6 GHz auf 3,4 GHz übertaktet wird (d. h. mit überhöhter Geschwindigkeit betrieben wird), steigt der Energiebedarf auf 83 Watt. Also doppelte Frequenz bei fast verdoppelter Verlustleistung. Leistungsstarke CPUs, z. B. der „Pentium Dual Core D 840“ mit 2 x 3,2 GHz verwandelt 140 Watt in Wärme, der „Athlon 64 X2 6400+“ 124 Watt. Wie kann die Geschwindigkeit noch weiter gesteigert werden?

Die Dual Core D840 CPU hat eine Fläche von 2 cm2 und verwandelt 140 Watt in Wärme. Das ergibt eine Heizleistung von 70 W/cm2 (140 W auf 2 cm2 Fläche des Prozessors). Wie bescheiden wirkt dagegen die Hitze einer Kochplatte: Bei 18 cm Durchmesser hat sie eine Fläche von etwa 250 cm2. Bei einer Leistung von 750 Watt ergibt das nur 3 W/cm2. Ich hoffe, es ist jetzt verständlich, wie wichtig eine gute Kühlung ist. Eine weitere Erhöhung der Frequenz um 20% hätte 19% mehr Wärme erzeugt.

Es wurde faktisch unmöglich, durch Erhöhung der Taktfrequenz mehr Leistung zu erreichen. Intel und AMD mussten deshalb das Wettrennen um die meisten Gigahertz etwa gleichzeitig im Jahr 2004 beenden und nach neuen Wegen zur Leistungssteigerung suchen. Eine der Möglichkeiten ist die Verkleinerung der Strukturen. Stark vereinfacht gesagt: Dünnere Leiter enthalten weniger Atome, deshalb müssen weniger Elektronen in Bewegung gesetzt werden, damit ein Strom fließt. Eine weitere Möglichkeit sind Mehrkernprozessoren: Die am höchsten belasteten Baugruppen in der CPU wie z. B. das Rechenwerk sind mehrfach vorhanden. Sie teilen die Arbeit untereinander auf und werden deshalb weniger heiß.

„Turbo-Modus“ ist die Fähigkeit der CPU, abhängig von der Auslastung der Kerne und der CPU-Temperatur den Takt kurzzeitig zu erhöhen, sogar zu verdoppeln. Die CPU überwacht ständig die Temperatur ihrer Hauptkomponenten. Wenn ein Kern zu heiß wird, macht er eine Abkühlpause und einer der kühleren Kerne übernimmt die Arbeit. Wenn die Anwendung nur einen der Kerne benutzt, kann dieser höher getaktet werden, während ungenutzte Kerne abkühlen. Die Technologie Turbo-Boost Max ermittelt den Kern, der momentan am höchsten übertaktet werden kann, und weist diesem Kern die wichtigste (zeitkritischste) Aufgabe zu.

„Speedstep“ ist die Fähigkeit der CPU, bei geringer Belastung den Takt automatisch zu verringern. Es wird Strom gespart und die in der CPU angesammelte Wärmemenge wird allmählich abgebaut. Wenn die nächste „Turbo-Modus-Phase“ beginnt, kann die CPU etwas länger durchhalten, bis sie gedrosselt werden muss.

Intel und AMD

Unter den Prozessorherstellern ist die Firma Intel der Marktführer. AMD ist der zweitgrößte Hersteller. AMD konnte 2005 mit der Prozessorfamilie „Athlon“ Intel eine Zeit lang in der Leistung überflügeln. Im Jahr 2005 hatte AMD ein höheres Wachstum als Intel. Im Jahr 2006 gelangte Intel mit den Core-Prozessoren wieder an die Spitze. Intel hatte Anfang 2019 bei CPUs für Desktop und Notebooks einen Marktanteil von zwischen 80 und 85 %. Mit den „Ryzen“-CPUs liegt AMD bei 15 bis 20 % mit leicht steigender Tendenz. Bei Server-Prozessoren hat Intel einen Marktanteil von 97 %.

Prozessoren zu entwickeln ist aufwändig. Intel gibt an, dass die Kosten für die Entwicklung des ersten Pentium höher waren als der Kaufpreis eines komplett ausgerüsteten Flugzeugträgers. Nur noch wenige Firmen können sich die hohen Entwicklungskosten leisten.

Marktanteile zu erringen ist nicht einfach. Ein Hersteller kann seine Prozessoren nur verkaufen, wenn sie „befehlskompatibel“ zu Intel-Prozessoren sind. Befehlskompatibel bedeutet, dass alle Befehle das gleiche Resultat liefern müssen wie das Intel-Original. Für einen nicht kompatiblen Prozessor würde es keine Software geben, der Hersteller müsste ein eigenes Windows und alle Anwendungsprogramme selbst entwickeln. Jeder Hersteller kann natürlich zusätzliche Befehle einbauen und darauf hoffen, dass die Softwarehersteller diese auch benutzen werden.

Beim 386er hatte IBM Bedenken, von einem einzigen Prozessorhersteller abhängig zu sein. Intel wurde genötigt, der Firma AMD die Fertigungsunterlagen zu überlassen. Damals konnte jeder Kunde frei wählen, ob er auf seine Hauptplatine einen Intel- oder AMD-Prozessor stecken will. Diese Vereinbarung ist längst ausgelaufen.

Heute muss jeder Prozessorhersteller die interne Schaltung und die Anschlüsse seiner CPU anders aufbauen als die Konkurrenz, um nicht wegen Patentverletzung verklagt zu werden. Deshalb gibt es zunehmende Unterschiede in der internen Architektur der Prozessoren verschiedener Hersteller. Das bedeutet leider auch, dass die Hauptplatinen für Intel- und AMD-CPUs unterschiedlich sind. Sie können nicht probeweise eine AMD-CPU durch eine Intel-CPU ersetzen.

Unterschiede im Design

Intel favorisiert ein Design, bei dem die Recheneinheiten des Prozessors pro Takt etwas weniger leisten (und deshalb weniger warm werden), wodurch man den Prozessor etwas höher takten kann. Bei anderen Architekturen ist der Fall eher umgekehrt: bei mobilen CPUs und der sog. Core-Architektur (die Nachfolger des Pentium 4) wird mit geringer Taktfrequenz viel Leistung erreicht.

AMD hat sich für ein Design entschieden, bei dem die Recheneinheiten pro Takt mehr leisten. Außerdem steckt ein Teil vom Chipsatz im Gehäuse der CPU. Dadurch wird die CPU heißer und darf nicht so schnell getaktet werden. (Der Chipsatz ist der Daten-Rangierbahnhof zwischen CPU, Speicher und schnellen Peripherieeinheiten.)

Das macht es nicht einfach, die Leistung konkurrierender Prozessoren zu vergleichen. AMD verwendet deshalb einen Umrechnungsfaktor: Der Prozessor ... hat etwa die gleiche Leistung wie ein Prozessor mit xxx MHz sie hätte, aber er schafft diese Leistung mit einer kleineren Taktfrequenz von nur yyy MHz. Das wird "P-Rating" genannt und vergleicht die Leistung mit einem imaginären Athlon Thunderbird.

Welcher Prozessor ist besser – Intel oder AMD? (oder vielleicht sogar ARM?)

Weil und solange die übergroße Mehrheit aller Programmentwickler einen Intel-Prozessor in ihren Test-PCs hat (oder gar ein Mehrprozessorsystem), werden Programme auf Intel-Prozessoren gründlicher getestet und haben deshalb weniger Fehler. Für professionelle Anwendungen, wo Sicherheit und Minimierung des Absturzrisikos extrem wichtig sind, ist eine Intel-CPU mit einem Intel-Chipsatz („Alles aus einer Hand“) die beste Paarung. Ein Athlon mit nVidia-Chipsatz dürfte die zweitbeste Paarung sein. Wenn das Preis-Leistungs-Verhältnis wichtig ist, liegt meist AMD vorn. Außer den genannten Prozessoren, sind erste Desktop und Netbook Rechner mit ARM CPU erhältlich. Zurzeit werden sie häufig mit dem Betriebssystem Android von Google ausgeliefert und zeichnen sich durch besonders geringe Anschaffungskosten und minimalen Stromverbrauch aus. Auch ihre Rechenleistung ist nicht zu unterschätzen. Ein Beispiel für Prozessoren dieser Familie ist der NVIDIA Tegra 2. Das Betriebssystem Windows ist zurzeit nicht für Geräte dieser Art verfügbar, auch wenn der Hersteller verlauten lässt, daran zu arbeiten. Für Benutzer, die sich durch ihr Smartphone bereits an Android gewöhnt haben, können diese Geräte jedoch eine echte Alternative darstellen.

Celeron, Duron und Sempron

Normale Büroluft enthält einige hunderttausend feinster Staubteilchen pro Liter. CPUs werden in Reinsträumen produziert, in denen pro Liter Luft maximal ein Staubkorn vorkommen darf. Prozessoren sind nur wenige Quadratmillimeter groß, und nicht jedes Staubkorn fällt auf einen Prozessor. Wenn es trifft, verursacht es verheerende Schäden. Ist nur einer von Millionen Transistoren defekt, ist der Chip unbrauchbar. Es gibt allerdings eine Ausnahme: Wenn der Schaden nur eine Hälfte des internen Cache betrifft und die andere Hälfte des Cache fehlerfrei ist, wird die defekte Hälfte des Cache abgeschaltet. Das kommt nicht selten vor, denn der interne Cache belegt etwa die Hälfte der Schaltkreisfläche und ist von Fehlern relativ oft betroffen. Der Chip wird mit halbem Cache unter dem Markennamen Celeron (intel) oder Duron (AMD) zu einem deutlich geringeren Preis verkauft. Diese Prozessoren schaffen noch etwa 80% der Leistung des vollständigen Prozessors und sind ansonsten voll kompatibel und fehlerfrei. Für viele Büro- und Heim-PC reicht das aus.

AMD produziert anstelle des Duron jetzt den "Sempron", Intel bietet immer noch den "Celeron" an. Wenn die Nachfrage nach CPUs im unteren Leistungssegment sehr groß ist, werden auch schon mal vollständig intakte CPUs durch Verkleinern des internen Cache, das Abschalten einiger Kerne oder andere Maßnahmen „abgespeckt“. So können die Prozessorhersteller relativ schnelle, moderne Prozessoren im unteren Preissegment anbieten, ohne die Preise für die „vollständigen“ Prozessoren zu senken.

Benchmarks

Um die Leistung heutiger CPUs zu vergleichen, reicht ein Blick auf die Taktfrequenz nicht aus. Größe und Organisation des Cache-Speichers, die Qualität der Vorschaulogik, die interne Arbeitsteilung zwischen den CPU-Baugruppen und Designunterschiede haben entscheidende Bedeutung. Heute beurteilt und vergleicht man die Leistung von CPUs mit speziellen Testprogrammen, sogenannten „Benchmarks“. Diese Testprogramme lassen den PC ein Sortiment vorgegebener Aufgaben aus einem bestimmten Themengebiet lösen (z. B. die Konvertierung eines Videos). Die dafür benötigte Zeit wird gestoppt und mit der Konkurrenz verglichen. Fachzeitschriften sind voll mit solchen Tests.

Was taugen die Benchmarks?

Leider kann man keinen der vielen Benchmarks als den besten empfehlen. Das Problem ist: Je nachdem, wofür Sie Ihren PC nutzen, sind unterschiedliche Kriterien wichtig. Betrachten wir zwei Beispiele.

Nicht nur die Server von Google haben große Datenmengen zu speichern. In Servern werden viele Festplatten parallelgeschaltet, die gewaltige Datenströme liefern können. Die Leistung eines Servers wird vor allem danach beurteilt, wie schnell er Daten von den Festplatten zu den Netzwerkkarten und umgekehrt transportieren kann. Der Arbeitsspeicher kann gar nicht groß genug sein. Die Leistung der Grafikkarte ist irrelevant. Die Rechenleistung der CPU spielt oft eine untergeordnete Rolle.

Ein PC, der die neuesten Spiele bewältigen soll, braucht vor allem eine hervorragende Grafikkarte und einen guten Prozessor. Die Leistung der Festplatte ist etwas weniger wichtig.

Es gibt also keinen Allround-Benchmark, sondern man braucht für jede Benutzergruppe andere.

Tipp: Welcher Prozessor steckt in Ihrem PC? Wenn Sie mit Windows arbeiten, klicken Sie mit der rechten Maustaste auf „Arbeitsplatz“, dann mit der linken Taste auf „Eigenschaften“. Dort finden Sie Angaben zu Ihrer CPU.

Wenn Sie mit Linux arbeiten, können Sie sich auf der Shell die Daten der CPU ihres Systems mit folgenden Befehl anschauen: cat /proc/cpuinfo

Wenn Sie mit MacOS arbeiten, klicken Sie im Apfel-Menü mit der linken Taste auf „Über diesen Mac“. Dort finden Sie die Angaben zu Ihrer CPU.

Der Cache-Speicher des Prozessors

Der Cache-Speicher des Prozessors

Was ist das - ein Cache?

Wenn die CPU ein Byte aus dem RAM braucht, muss sie lange warten. Wenn die CPU das Byte fünf Mal braucht, muss sie fünf Mal warten. Als Abhilfe bekommt die CPU einen Cache und einen Cachecontroller. Das Wort „Cache“ wird mit Zwischenspeicher, Pufferspeicher, geheime Vorratskammer oder geheimes Lager übersetzt. „Geheim“ bedeutet in diesem Zusammenhang, dass von außen nicht sichtbar ist, was sich darin abspielt.

Bei jedem Lesezugriff der CPU auf den Arbeitsspeicher wird eine Kopie der gelesenen Daten im Cache gespeichert. Wenn die CPU ein Byte zum ersten Mal anfordert, ist es noch nicht im Cache-Speicher. Das nennt man einen „Cache-Miss“. Wird dieses Byte kurz nach der ersten Verwendung erneut angefordert, findet es der Cache-Controller im Cache. Einen solchen „Treffer“ nennt man „Cache-Hit“. Die CPU bekommt das Byte aus dem Cache und muss nicht auf den Arbeitsspeicher warten.

Der Speicherbus ist seit dem ersten Pentium 64 Bit breit. Der Arbeitsspeicher liest stets acht Byte, niemals ein einzelnes Byte. Entsprechend merkt sich auch der Cache acht benachbarte Byte als „Cache-Line“, sprich „kesch-lain“. Wenn die CPU ein benachbartes Byte anfordert, kann sie aus dem Cache bedient werden.

Ein Festplattencache ist Bestandteil der Festplattenelektronik. Wenn ein Teil einer Spur von der CPU angefordert wird, speichert der Cache den Rest der Spur für eventuelle spätere Anfragen.

CD- und DVD-Brenner benutzen einen Cache. Dadurch reißt der Datenstrom nicht ab, wenn es zu kleinen Verzögerungen beim Nachschub der zu brennenden Daten kommt. Auch beim Lesen hilft der Cache, vor allem bei transportablen Playern: wenn der Lesekopf wegen eines Schlagloches die Spur verloren hat, kommt die Musik übergangsweise aus dem Cache.

Im Inneren der CPU gibt es einen Prozessor-Cache, um den es im Weiteren geht.

Warum braucht die CPU einen Cache?

In den ersten CPUs gab es drei zeitlich getrennte Phasen:

Die CPU beauftragt die Speichersteuerung, einen Befehl und die zugehörigen Daten aus dem Speicher zu holen, und wartet geduldig, bis der Speicher die bestellten Bytes liefert. Sind die Daten eingetroffen, führt die CPU den Befehl aus. Inzwischen wartet der Speicher, denn erst nach Ausführung des Befehls steht fest, welcher Befehl und welche Daten als nächste gebraucht werden. Das Ergebnis der Berechnung wird in den Speicher zurückgeschrieben.

Dabei geht viel Zeit verloren, weil CPU und Speicher immer nur abwechselnd arbeiten. Dieser Geschwindigkeitsverlust lässt sich durch ein „Prefetch“ genanntes Verfahren der „Vorratshaltung“ vermindern: Eine Baugruppe der CPU holt die nächsten Befehle im Voraus und hält sie in einem Zwischenspeicher, dem Cache, solange bereit, bis sie von der CPU gebraucht werden. Seit dem ersten Pentium laufen das Heranschaffen der Daten und deren Verarbeitung weitgehend gleichzeitig ab.

Pentium Pro, links: Steuer- und Recheneinheiten, rechts: Cache Level II, erkennbar an der regelmäßigen Struktur

Der Prozessor-Cache ist ein kleiner, schneller Speicher, der Kopien von den am häufigsten benötigten Daten des Arbeitsspeichers enthält. Wenn der Prozessor Daten aus dem Arbeitsspeicher anfordert, prüft die Elektronik blitzschnell, ob von den benötigten Daten vielleicht schon eine Kopie im Cache-RAM existiert. Wenn ja (ein „Cache-Hit“), erhält die CPU die Daten noch im selben Takt. Wenn nein (ein „Cache-Miss“), wird die Anforderung an den Arbeitsspeicher weitergegeben. Die CPU muss warten, d. h. einige Wartetakte einlegen, oder vorübergehend zu einer anderen Aufgabe wechseln (Hyper-Threading).

Die Strategie der Cache-Nutzung

Irgendwann ist der Cache voll und es muss Platz für neue Daten frei gemacht werden. Der Cache-Controller muss eine Kombination der folgenden Kriterien benutzen, um Entscheidungen zu treffen:

Welche Daten sind in den letzten Mikrosekunden am häufigsten benutzt worden,

Welche Daten werden voraussichtlich demnächst benötigt und

Welche Daten werden voraussichtlich nicht mehr benötigt und können deshalb entfernt werden, um Platz zu schaffen.

Vorausschauendes Lesen

Bevor das Rechenwerk der CPU einen Befehl ausführen kann, haben andere Baugruppen der CPU schon die Vorarbeit geleistet: Sie haben für etwa 5 bis 15 Befehle im Voraus analysiert, welche Daten für diese Befehle benötigt werden, um diese Daten frühzeitig heranzuschaffen. Dadurch kann das Rechenwerk meistens mit voller Geschwindigkeit arbeiten.

Verzögertes Schreiben

Jedes von der CPU berechnete Ergebnis wird zunächst im Cache gespeichert. Wenn das Ergebnis eines Rechenschrittes in einem der nachfolgenden Rechenschritte weiterverwendet wird, kann die CPU ohne Wartezeit darauf zugreifen. Zwar muss das Ergebnis irgendwann in den langsamen Arbeitsspeicher abtransportiert werden, aber das wird vorzugsweise dann erledigt, wenn es mal keine Leseanforderungen an den Arbeitsspeicher gibt.

Sprungvorhersage

Das Problem ist: Woher „wissen“ die elektronischen Schaltungen, welche Daten demnächst „voraussichtlich benötigt“ werden?

„Am häufigsten benutzt“, „voraussichtlich benötigt“ und „voraussichtlich nicht mehr benötigt“ – die Zukunft vorauszusagen, war noch nie einfach. Wie kann die Elektronik voraussehen, was zukünftig benötigt werden wird? Die Treffsicherheit dieser Voraussage ist für die Geschwindigkeit der CPU entscheidend.

Jedes Programm enthält eine große Anzahl Verzweigungsbefehle. So nennt man die Befehle, bei denen die CPU in Abhängigkeit von einem Zwischenergebnis entscheiden muss, wie es weitergeht. Beispiel bei der Musikausgabe: Ist die nächste Note eine Achtel-, Viertel- oder ganze Note? Kommt noch eine weitere Note oder ist das Ende des Musikstückes erreicht? Die „Vorausschau-einheit“ der CPU kann das nicht ermitteln und stellte bei frühen Prozessoren die Arbeit ein, bis das Rechenwerk den Verzweigungsbefehl bearbeitet und über den weiteren Programmverlauf entschieden hat. Dadurch tritt allerdings eine Pause ein, weil die Vorausschaueinheit erst die Daten für die Weiterarbeit heranschaffen muss.

Seit Jahren arbeiten die Prozessorhersteller daran, wie die Elektronik die wahrscheinlichste Programmfortsetzung immer besser vorhersagen kann (die „Branch Prediction“ = Sprung-vorhersage). Hat die Elektronik gut „geraten“ und die richtigen Daten vorbereitet, kann das Rechenwerk zügig weiterarbeiten. „Falsch spekuliert“ bedeutet, dass die Kopien der vorausschauend bereitgestellten Daten verworfen werden und das Rechenwerk warten muss.

Aktuelle CPUs haben 2 bis 22 MB Cache. Obwohl der Hauptspeicher etwa tausend mal größer ist, schafft es die Cache-Verwaltung mit ausgefeilten Algorithmen, beachtliche 80 % bis 90 % der vom Prozessor benötigten Daten rechtzeitig im Cache bereitzustellen.

64-Bit-Verarbeitungsbreite